在當今數字時代,大數據已成為企業決策和創新的關鍵驅動力。大數據的處理流程是一個系統化的過程,涉及從數據采集到最終應用的多個階段,而數據處理服務則提供了專業的技術支持,幫助企業高效應對數據挑戰。以下是詳細的介紹。

一、大數據的處理流程

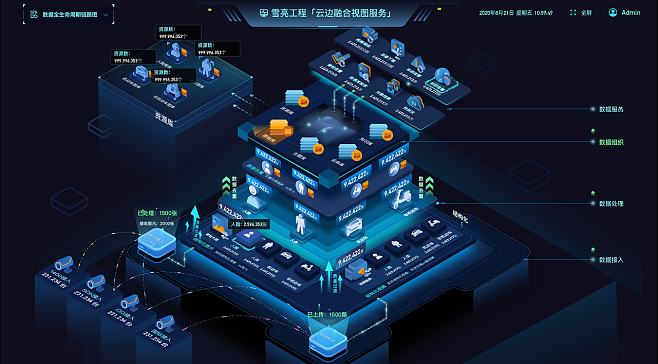

大數據的處理流程通常包括以下幾個核心步驟,形成一個閉環的數據生命周期管理:

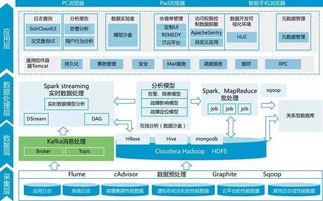

- 數據采集:這是流程的起點,涉及從各種來源(如傳感器、社交媒體、交易記錄等)收集原始數據。數據可能以結構化、半結構化或非結構化的形式存在,例如日志文件、圖像或視頻。采集工具包括Flume、Kafka等,確保數據實時或批量流入系統。

- 數據存儲:收集到的數據需要被存儲在可靠的系統中,以便后續處理。常見的存儲方案包括分布式文件系統(如HDFS)、NoSQL數據庫(如MongoDB)和云存儲服務。這一步驟強調可擴展性和容錯性,以應對海量數據。

- 數據處理:這是核心環節,包括數據清洗、轉換和聚合。數據處理可以采用批處理(如使用Hadoop MapReduce)或流處理(如使用Spark Streaming)方式。通過去除噪音、標準化格式和提取關鍵特征,數據被轉化為可用格式。

- 數據分析:處理后的數據通過分析工具(如機器學習算法、統計分析)挖掘洞察。這可能包括描述性分析(總結歷史數據)、預測性分析(預測未來趨勢)或規范性分析(提供決策建議)。

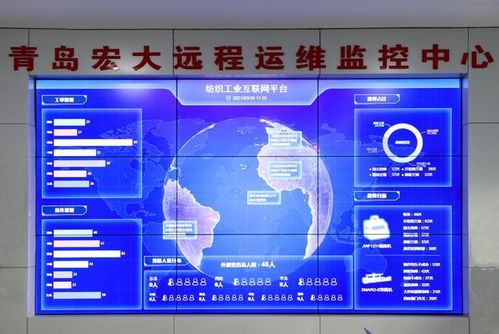

- 數據可視化與應用:分析結果通過可視化工具(如Tableau、Power BI)呈現,幫助用戶理解數據。最終,數據被應用于業務場景,如推薦系統、風險監控或運營優化,實現數據驅動決策。

整個流程強調迭代和反饋,隨著新數據的流入,系統不斷優化處理策略。

二、數據處理服務

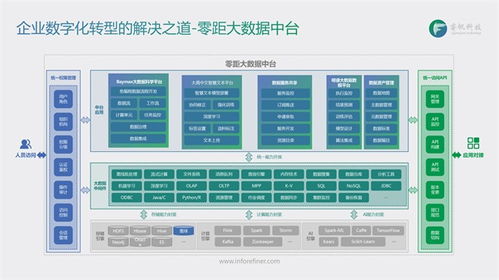

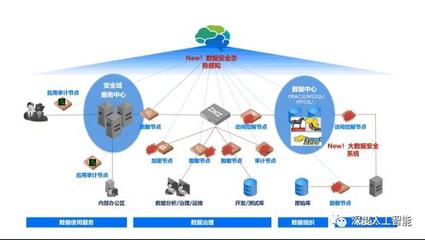

數據處理服務是指由專業提供商提供的端到端解決方案,旨在幫助企業簡化大數據處理流程。這些服務通常基于云計算平臺,提供以下優勢:

- 可擴展性:服務提供商(如AWS、Azure、Google Cloud)提供按需資源,企業無需投資昂貴硬件即可處理峰值負載。

- 成本效益:采用按使用付費模式,降低前期投資和運維成本。

- 專業化工具:集成先進的數據處理框架(如Apache Spark、Flink),并提供預構建的管道,加速數據集成和分析。

- 安全與合規:服務包括數據加密、訪問控制和合規性檢查,確保數據隱私和法規遵循。

- 支持與維護:提供商負責系統更新、監控和故障排除,讓企業專注于核心業務。

常見的服務包括數據清洗服務、實時流處理服務、數據倉庫服務(如Snowflake)以及AI驅動的分析平臺。企業可以根據需求選擇定制化服務,提升數據處理效率和質量。

大數據的處理流程是一個從采集到應用的完整鏈條,而數據處理服務則提供了專業、靈活的支持,幫助組織應對數據復雜性。隨著技術發展,這些流程和服務將不斷演進,推動更多行業實現數字化轉型。